Inhaltliche Erschließung mit KI:

Warum es nur beim Feierabend-Projekt geblieben ist

Noch bevor mein neues Business seine Türen offiziell geöffnet hat, also im Dezember, bekam ich eine Anfrage nach Unterstützung bei der Evaluierung von KI-Tools bei der Inhaltserschließung. Man hatte von ALIMA gehört und war angetan, nachdem zuvor schon Überlegungen zum Einsatz von Annif gelaufen waren. Das Institut war mir bekannt und auch der große Wert, der auf tiefe inhaltliche Erschließung dort gelegt wird: Allein die Systematik umfasst achtzig Seiten. Ich konnte also eine gewisse Skepsis nicht verhehlen: Wie würden die Trainingsaufwände ausfallen, wenn ich es denn überhaupt schaffen würde, eine entsprechende Testumgebung aufzusetzen?

Glücklicherweise hat mir das letzte Jahr einen exponentiellen Zuwachs an Mut beim Umgang mit Open Source-Software eingebracht. Ein Repository von GitHub herunterladen, zum Laufen bringen, die Funktionen verstehen und eine Einschätzung über die Anpassbarkeit gewinnen? Da bin ich inzwischen unerschrockener denn je und dank Unterstützung von KI-unterstützten Entwicklungsumgebungen auch vertretbar kompetent und schnell.

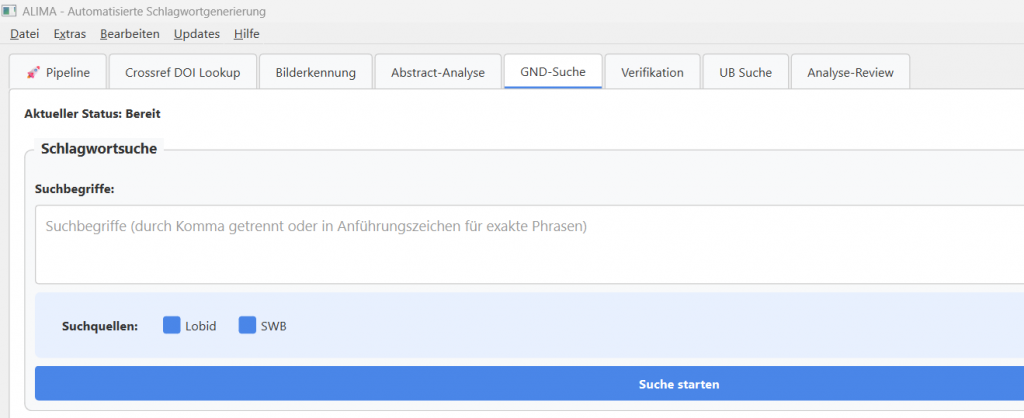

Ich habe also ALIMA aus dem GitHub-Repository von Conrad Hübler installiert und habe es tatsächlich geschafft, in einem Feierabend-Projekt vernünftig aussehende GND-Schlagworte zu erzeugen. An der klassifikatorischen Erschließung bin ich im ersten Anlauf gescheitert, weil ich keine passende Katalog-Schnittstelle für das Institut zur Hand hatte. Die hätte ALIMA gebraucht, um auf Grundlage von bereits systematisierter Titel Vorschläge für die Einordnung von Neuaufnahmen zu generieren.

An der Stelle habe ich innegehalten, und nicht nur, weil bald Weihnachten war: Welche Medien sollten überhaupt erschlossen werden? Für elektronische Volltexte konnte ich mir das gut vorstellen, für Print-Titel, für die nur bibliografische Metadaten vorliegen? Wie viele Experimente mit unterschiedlichen Modellen würden notwendig sein, was würde das kosten? Und ganz lebenspraktische Fragen: Würde ALIMA auf einem normalen Mitarbeitenden-PC laufen? Wie hoch würden die Ansprüche an die Automatisierung des Workflows sein? Sollten Metadaten von Neuaufnahmen automatisiert abgeholt, angereichert und wieder in das Bibliotheksmanagement-System eingespielt werden?

Es war also Zeit für Rücksprache mit dem Institut, denn neben der Klärung der Erwartungen galt es auch zu besprechen, welches Projektsetting für die weitere Arbeit sinnvoll sein würde: Die Bezifferung von Aufwänden für eine lauffähige und für das Institut angepasste Implementierung von ALIMA schien mir mittelfristig unmöglich, man würde also kleine Teilziele definieren und auf Basis von Stundenkontingenten abrechnen müssen – nicht unbedingt das Lieblings-Szenario von Vergabestellen, zumindest in meiner Erfahrung.

Alte Schule: Klassifikatorische Inhaltserschliéßung von Print-Beständen

Die Videokonferenz mit dem Institut verstärkte meine Skepsis: Es sollte tatsächlich um Print-Bestände gehen. Während die Workflow-Automatisierung weniger im Mittelpunkt stehen sollte, ging es doch darum, ähnlich gute Ergebnisse wie ein langjähriger Fachreferent zu erzielen und manuelle Nachprüfungen möglichst auszuschließen. Mein Eindruck am Ende war: Wenn die von ALIMA vorgeschlagenen Systemstellen zusätzliche Nachdenk-Prozesse und gar Re-Systematisierungen von bestehenden Titeln bewirken sollten, wäre nicht viel gewonnen. Der Mensch müsste möglichst vollständig aus dem Prozess herausgenommen werden. Aber lässt sich das Vertrauen dafür aufbauen?

Und außerdem: Wie würde sich die Frage der inhaltlichen Erschließung im Institut weiterentwickeln? Würde man ggf. andere Formen der Aufstellung wählen? Würde die sorgsame und vielleicht sogar doppelte Erschließung durch Maschine und Mensch nicht ohnehin durch KI-gestützte Recherchetools noch weiter in den Hintergrund rücken?

Ich hätte ein Projekt auf Stundenbasis angenommen – nicht nur, weil ich in der frühen Phase meiner Gründung darauf angewiesen bin, sondern weil ich glaube, dass nicht nur dieses eine Institut, sondern der ganze Berufsstand relevante eigene Erfahrungen im Umgang mit den Möglichkeiten der KI-gestützten Erschließung braucht. Mit dem Institut war ich mir einig, dass genau das der Mehrwert einer Beratungsphase mit mir darstellte .

Dennoch hat sich das Institut – für mich nachvollziehbar – dagegen entschieden. Ich darf zitieren:

Vielleicht müssen wir, d. h. an dieser Stelle konkret: ich, einfach „vorsintflutlich“ wie bisher die Sacherschließung hier weiterbetreiben, bis in einer neuen Zeit (wohl erst in einigen Jahren) radikal neue Wege in der hiesigen Bibliothek technisch und organisatorisch beschritten werden können und müssen, d. h. die (stark veraltete Systematik) komplett aufzugeben sein wird, Numerus Currens für den physischen Bestand hier eingeführt werden wird und die inhaltliche Suche auf völlig neue (technische) Füße zu stellen sein wird.

Nun bin ich hin- und hergerissen: Das Projekt wäre sicherlich anspruchsvoll geworden und hätte nicht zu schneller Entlastung des Fachreferenten und zügigeren Workflows geführt, zugleich aber sicherlich viele praktische Fragen bei den Fragen des Datenaustausches mit dem LMS aufgeworfen. Ich verstehe die Absage gut und bewundere die oben zitierte klare Analyse.

Was nachklingt, sind größere Fragen für uns alle: Wann beginnt die neue Zeit? Woran werden wir merken, dass sie da ist? Was wird uns dazu befähigen, die angesprochenen „radikal neuen Wege“ zu gehen? Warten wir Bibliothekswesen auf einen Urknall, oder ist es eher ein Warten auf Godot? Vielleicht sind das zu große Fragen, vielleicht ist es aber wie so oft bei großen, unwägbaren Zielen: Der Weg ist nur in kleinen Etappen machbar.